Lidando com o preconceito de treinamento em aprendizado de máquina

Ensinar qualquer pessoa sobre “justiça” é uma meta louvável.

Como humanos, podemos não necessariamente concordar sobre o que é justo. Às vezes, depende do contexto. Ensinar as crianças a serem justas - em casa e na escola - é fundamental, mas é mais fácil falar do que fazer. Com isso em mente, como podemos, como sociedade, comunicar as nuances de “ser justo” aos sistemas de inteligência artificial (IA)?

Uma equipe de pesquisadores da IBM Research está descobrindo este enigma pela primeira vez. A IBM está lançando um kit de ferramentas para desenvolvedores chamado “AI Fairness 360”. Como parte desse esforço, a IBM está oferecendo às empresas um novo “serviço baseado em nuvem, detecção de polarização e mitigação” que as corporações podem usar para testar e verificar como os sistemas orientados por IA estão se comportando.

Em uma entrevista por telefone com EE Times, Saska Mojsilovic, um Fellow da IBM Research, nos disse que os cientistas e praticantes de IA têm se concentrado demais na precisão da IA. Normalmente, a primeira pergunta que as pessoas fazem sobre IA é:"As máquinas podem vencer os humanos?"

Mas e quanto à justiça? O vazio de justiça na IA tem o potencial de induzir consequências catastróficas em, por exemplo, assistência médica ou veículos autônomos, disse ela.

E se um conjunto de dados usado para treinar uma máquina for tendencioso? Se a IA não consegue explicar como chegou a uma decisão, como podemos verificar se está "certo"? A IA pode revelar se os dados foram de alguma forma manipulados durante o processamento da IA? A IA poderia nos garantir que seus dados nunca foram atacados ou comprometidos, inclusive durante o pré e pós-processamento?

Em suma, existe algo como IA introspectiva? A resposta simples:Não.

Sem serem transparentes para os usuários, desenvolvedores e profissionais de IA, os sistemas de IA não podem ganhar a confiança da sociedade, disse Mojsilovic.

Decompondo justiça

Uma questão maior é como ensinar à máquina o que é justiça. Mojsilovic observou:"Por sermos cientistas, a primeira coisa que fizemos foi decompor a 'justiça'. Precisávamos colocar nossas mãos em torno disso." Eles quebraram a justiça em termos de métricas, algoritmos e tendências praticadas na implementação de IA.

Kush Varshney, Cientista Pesquisador da IBM, explicou que a equipe analisou o viés e a justiça nos algoritmos de IA e na tomada de decisões de IA. “Existe justiça para os indivíduos e existe justiça para os grupos. Observamos diferentes atributos de grupos - variando de gênero a raça. Questões jurídicas e regulatórias também são consideradas. ” No final, a equipe acabou medindo 30 métricas diferentes para procurar viés em conjuntos de dados, modelos de IA e algoritmos.

Essas descobertas foram incorporadas à caixa de ferramentas AI Fairness 360 que a IBM lançou esta semana. A empresa o descreveu como "um kit de ferramentas de código aberto abrangente de métricas para verificar tendências indesejadas em conjuntos de dados e modelos de aprendizado de máquina".

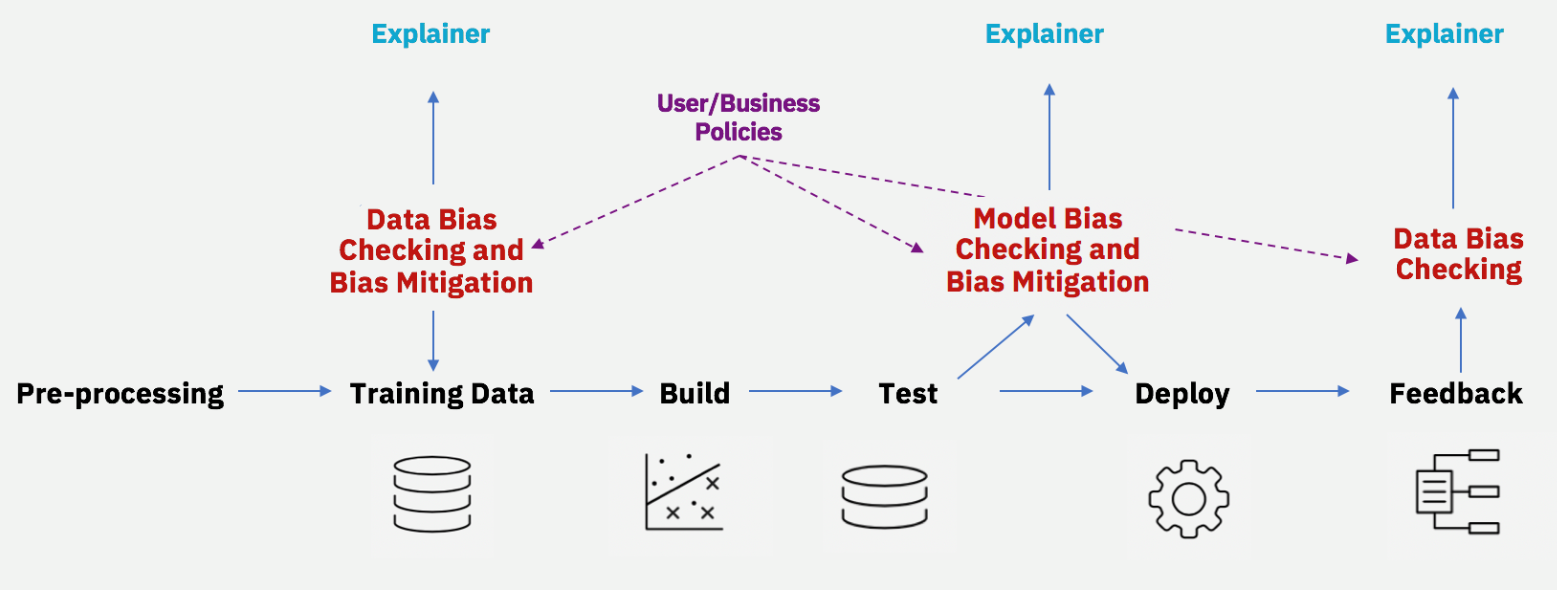

Mitigando o viés ao longo do ciclo de vida da IA (Fonte:IBM)

Embora muitos cientistas já estejam trabalhando para detectar a discriminação em algoritmos de IA, Mojsilovic disse que a abordagem da IBM difere ao incluir algoritmos não apenas para encontrar o viés, mas também uma ferramenta para eliminar o viés.

Em um nível básico, você deve perguntar:Cientistas da computação - definindo justiça? Essa é uma tarefa normalmente atribuída a cientistas sociais? Ciente dessa incongruência, a IBM deixou claro que nem Mojsilovic nem Varshney estão trabalhando no vácuo. Eles trouxeram uma série de acadêmicos e institutos. Varshney participou da Conferência de Ética Uehiro-Carnegie-Oxford patrocinada pelo Conselho Carnegie de Ética em Assuntos Internacionais. Mojsilovic participou de um workshop de IA em Berkeley, Califórnia, patrocinado pela UC Berkeley Law School.

Um algoritmo é neutro?

Cientistas sociais têm apontado a questão do preconceito da IA há algum tempo.

Young Mie Kim, professora da Escola de Jornalismo e Comunicação de Massa da University of Wisconsin — Madison, explicou:“A discriminação de IA (ou preconceito de IA) pode acontecer quando implícita ou explicitamente reforça ordens sociais e preconceitos desiguais existentes (por exemplo, gênero, raça, idade, situação social / econômica, etc.). ” Os exemplos variam de erros de amostragem (por exemplo, sub-representação de certos dados demográficos devido a métodos inadequados ou dificuldades em métodos de amostragem) a tendências humanas no treinamento de máquina (modelagem). Kim argumentou que o viés da IA existe mesmo com “decisões estratégicas” em design ou modelagem, como algoritmos de propaganda política.

Em seu estudo recente intitulado “Oportunidade Algorítmica:Publicidade Digital e Desigualdade de Envolvimento Político”, Kim demonstrou como a desigualdade pode ser reforçada em decisões baseadas em algoritmos.

A comunidade técnica pode argumentar que “um algoritmo é neutro” ou pode ser “educado” (treinado). Kim observou:“Isso não reconhece que os vieses entram em qualquer estágio do desenvolvimento do algoritmo.”

Tecnologia da Internet das Coisas

- Aprendizado de máquina na AWS; Saiba tudo

- A Cadeia de Suprimentos e o Aprendizado de Máquina

- Maximizando a eficácia do treinamento de confiabilidade

- Mobius apresenta o software de treinamento de balanceamento de máquina

- NXP duplica o aprendizado de máquina no limite

- Como usar o aprendizado de máquina no ambiente empresarial atual

- Aprendizado de máquina em campo

- Enfrentando a curva de aprendizado do PID

- Aprendizado de máquina na manutenção preditiva

- Preveja a vida útil da bateria com aprendizado de máquina