PyTorch vs TensorFlow:comparação detalhada

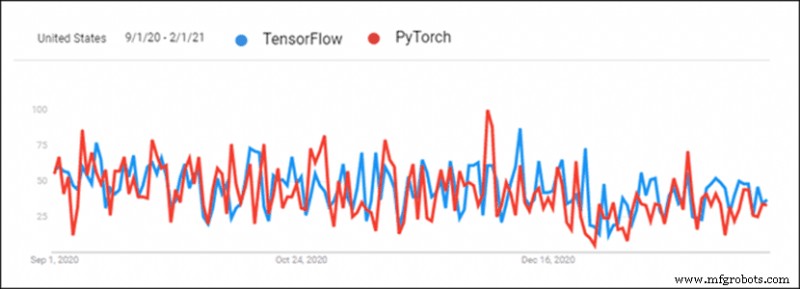

A crescente popularidade do aprendizado profundo criou uma competição saudável entre as estruturas de aprendizado profundo. O PyTorch e o TensorFlow se destacam como duas das estruturas de aprendizado profundo mais populares. As bibliotecas estão competindo frente a frente para assumir a liderança como a principal ferramenta de aprendizado profundo.

O TensorFlow é mais antigo e sempre teve uma liderança por causa disso, mas o PyTorch alcançou nos últimos seis meses. Há muita confusão sobre como fazer a escolha certa ao escolher uma estrutura de aprendizado profundo para um projeto.

Este artigo compara o PyTorch com o TensorFlow e fornece uma comparação detalhada das duas estruturas.

PyTorch x TensorFlow:uma visão geral

Tanto o PyTorch quanto o TensorFlow acompanham o que a concorrência está fazendo. No entanto, ainda existem algumas diferenças entre as duas estruturas.

Observação: Esta tabela é rolável horizontalmente.

| Biblioteca | PyTorch | TensorFlow 2.0 |

|---|---|---|

| Criado por | FAIR Lab (Facebook AI Research Lab) | Equipe do Google Brain |

| Baseado em | Tocha | Theano |

| Produção | Foco em pesquisa | Foco no setor |

| Visualização | Visão | Tensorboard |

| Implantação | Serviço da tocha (experimental) | Serviço TensorFlow |

| Implantação móvel | Sim (experimental) | Sim |

| Gerenciamento de dispositivos | CUDA | Automatizado |

| Geração de gráfico | Modo dinâmico e estático | Modo ansioso e estático |

| Curva de aprendizado | Mais fácil para desenvolvedores e cientistas | Mais fácil para projetos no nível do setor |

| U ses casos | Facebook CheXNet Tesla Piloto automático Uber PIR | Google Sinovação Empreendimentos PayPal China Celular |

1. Visualização

A visualização feita à mão leva tempo. O PyTorch e o TensorFlow possuem ferramentas para análise visual rápida. Isso facilita a revisão do processo de treinamento. A visualização também é ótima para apresentar resultados.

TensorFlow

Tensorboard é usado para visualizar dados. A interface é interativa e visualmente atraente. O Tensorboard fornece uma visão geral detalhada de métricas e dados de treinamento. Os dados são facilmente exportados e ficam ótimos para fins de apresentação. Os plugins também disponibilizam o Tensorboard para o PyTorch.

No entanto, o Tensorboard é complicado e complicado de usar.

PyTorch

PyTorch usa Visdom para visualização. A interface é leve e fácil de usar. Visdom é flexível e personalizável. O suporte direto para tensores PyTorch simplifica o uso.

O Visdom carece de interatividade e de muitos recursos essenciais para a visão geral dos dados.

2. Geração de gráfico

Existem dois tipos de geração de arquitetura de rede neural:

- Gráficos estáticos – Arquitetura de camada fixa. O mapa é gerado primeiro, depois os dados são enviados por ele.

- Gráficos dinâmicos – Arquitetura de camada dinâmica. O mapa é definido implicitamente com sobrecarga de dados.

TensorFlow

O TensorFlow usou gráficos estáticos desde o início. Os gráficos estáticos permitem a distribuição em várias máquinas. Os modelos são implantados independentemente do código. O uso de gráficos estáticos tornou o TensorFlow mais amigável à produção e flexível ao trabalhar com novas arquiteturas.

O TensorFlow adicionou um recurso que imita gráficos dinâmicos chamados de execução antecipada. O TensorFlow 2 é executado em execução antecipada por padrão. A geração de gráfico estático está disponível ao desativar a execução antecipada.

PyTorch

O PyTorch apresentou gráficos dinâmicos desde o início. Esse recurso colocou o PyTorch em competição com o TensorFlow.

A capacidade de alterar gráficos em movimento provou ser uma abordagem mais amigável para programadores e pesquisadores para a geração de redes neurais. Dados estruturados e variações de tamanho nos dados são mais fáceis de manusear com gráficos dinâmicos. O PyTorch também fornece gráficos estáticos.

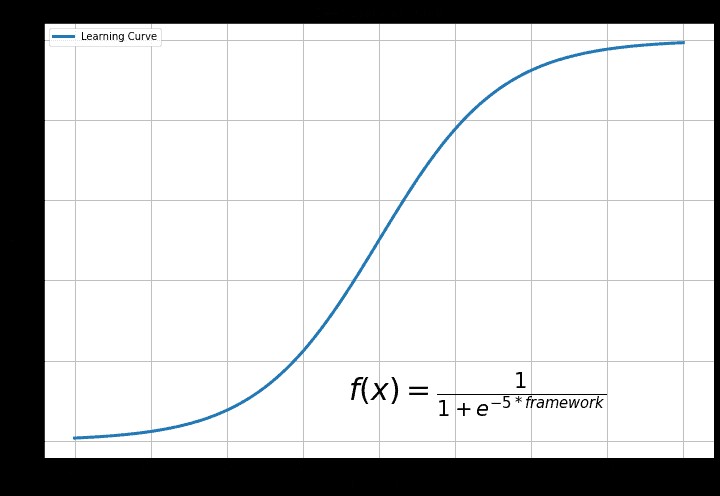

3. Curva de aprendizado

A curva de aprendizado depende da experiência anterior e do objetivo final de usar o aprendizado profundo.

TensorFlow

O TensorFlow é a biblioteca mais desafiadora. As funções Keras tornam o TensorFlow mais fácil de usar. Geralmente, o TensorFlow é difícil de compreender para alguém que está começando no aprendizado profundo.

A razão por trás disso é a funcionalidade diversificada do TensorFlow. Há muitos recursos para explorar e descobrir. Isso é uma distração e redundante para um iniciante.

PyTorch

PyTorch é a biblioteca mais fácil de aprender. O código é mais fácil de experimentar se o Python estiver familiarizado. Existe uma abordagem Pythonic para criar uma rede neural no PyTorch. A flexibilidade do PyTorch significa que o código é amigável para experimentos.

O PyTorch não é tão rico em recursos, mas todos os recursos essenciais estão disponíveis. O PyTorch é mais simples de começar e aprender.

4. Implantação

A implantação é uma etapa de desenvolvimento de software importante para as equipes de desenvolvimento de software. A implantação de software disponibiliza um programa ou aplicativo para uso do consumidor.

TensorFlow

O TensorFlow usa Serviço TensorFlow para implantação do modelo. Exibição do TensorFlow é projetado para ambientes de produção e indústria em mente. A implantação é flexível e de alto desempenho com uma API de cliente REST. Exibição do TensorFlow integra-se bem com Docker e Kubernetes.

PyTorch

O PyTorch começou recentemente a resolver o problema de implantação. Serviço da tocha implanta modelos PyTorch. Existe uma API RESTful para integração de aplicativos. A API PyTorch é extensível para implantação móvel. Serviço da tocha integra-se com o Kubernetes.

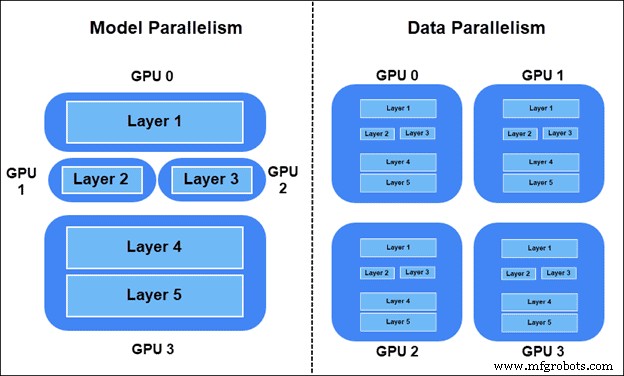

5. Paralelismo e Treinamento Distribuído

Paralelismo e treinamento distribuído são essenciais para big data. As métricas gerais são:

- Aumento de velocidade – Relação da velocidade de um modelo sequencial (uma GPU) em comparação com a velocidade do modelo paralelo (várias GPUs).

- Produtividade – O número máximo de imagens passadas pelo modelo por unidade de tempo.

- Escalabilidade – Como o sistema lida com o aumento da carga de trabalho.

Há duas maneiras de distribuir a carga de trabalho de treinamento:

- Paralelismo de modelo – Camadas do modelo divididas em diferentes dispositivos. Partes do gráfico são usadas no treinamento simultaneamente.

- Paralelismo de dados – Todos os dispositivos têm uma cópia de todo o modelo. Cada dispositivo treina em diferentes amostras de dados. O método síncrono SGD (Stochastic Gradient Descent) é o preferido.

Paralelismo do modelo TensorFlow

Para colocar parte do modelo em um dispositivo específico no TensorFlow, use

tf.device . Por exemplo, divida duas camadas lineares em dois dispositivos GPU diferentes:

import tensorflow as tf

from tensorflow.keras import layers

with tf.device(‘GPU:0’):

layer1 = layers.Dense(16, input_dim=8)

with tf.device(‘GPU:1’):

layer2 = layers.Dense(4, input_dim=16) Paralelismo do modelo PyTorch

Mova partes do modelo para diferentes dispositivos no PyTorch usando o

nn.Module.to método. Por exemplo, mova duas camadas lineares para duas GPUs diferentes:

import torch.nn as nn layer1 = nn.Linear(8,16).to(‘cuda:0’) layer2 = nn.Lienar(16,4).to(‘cuda:1’)

Paralelismo de dados do TensorFlow

Para fazer SGD síncrono no TensorFlow, defina a estratégia de distribuição com

tf.distribute.MirroredStrategy() e envolva a inicialização do modelo:import tensorflow as tf strategy = tf.distribute.MirroredStrategy() with strategy.scope(): model = … model.compile(...)

Depois de compilar o modelo com o wrapper, treine o modelo como de costume.

Paralelismo de dados PyTorch

Para SGD síncrono no PyTorch, envolva o modelo em

torch.nn.DistributedDataParallel após a inicialização do modelo e defina a classificação do número do dispositivo começando com zero:from torch.nn.parallel import DistributedDataParallel. model = ... model = model.to() ddp_model = DistributedDataParallel(model, device_ids=[])

6. Gerenciamento de dispositivos

Grandes mudanças no desempenho acontecem ao gerenciar dispositivos. Tanto o PyTorch quanto o TensorFlow aplicam bem as redes neurais, mas a execução é diferente.

TensorFlow

O TensorFlow muda automaticamente para o uso da GPU se uma GPU estiver disponível. Há controle sobre as GPUs e como elas são acessadas. A aceleração da GPU é automatizada. O que isso significa é que não há controle sobre o uso da memória.

PyTorch

PyTorch usa CUDA para especificar o uso de GPU ou CPU. O modelo não funcionará sem especificações CUDA para uso de GPU e CPU. O uso da GPU não é automatizado, o que significa que há um melhor controle sobre o uso de recursos. O PyTorch aprimora o processo de treinamento por meio do controle da GPU.

7. Casos de uso para ambas as plataformas de aprendizado profundo

O TensorFlow e o PyTorch foram usados pela primeira vez em suas respectivas empresas. Desde que se tornou código aberto, existem muitos casos de uso fora do Google e do Facebook também.

TensorFlow

Os pesquisadores do Google Brain Team usaram pela primeira vez o TensorFlow para projetos de pesquisa do Google. O Google usa o TensorFlow para:

- Resultados da pesquisa e preenchimento automático.

- Conversor de texto e tecnologia de voz.

- Reconhecimento e classificação de imagens.

- Sistemas de tradução automática.

- Detecção de spam para Gmail.

Existem muitos casos de uso fora do Google também. Por exemplo:

- Sinovation Ventures – Classificação e segmentação de doenças usando imagens de retinas.

- PayPal – Detecção de fraude com aprendizado de transferência profunda e modelagem generativa.

- China Celular – Sistemas de aprendizado profundo para detecção de problemas em redes, previsão automatizada de janelas de tempo de transição e verificação de logs de operação.

PyTorch

O PyTorch foi usado pela primeira vez no Facebook pelo Laboratório de Pesquisadores de Inteligência Artificial do Facebook (FAIR). O Facebook usa o PyTorch para:

- Reconhecimento facial e detecção de objetos.

- Filtragem de spam e detecção de notícias falsas.

- Automação de feed de notícias e sistema de sugestões de amigos.

- Reconhecimento de fala.

- Sistemas de tradução automática.

PyTorch é de código aberto. Agora existem muitos casos de uso fora do Facebook, como:

- CheXNet – Pontuação de probabilidade de pneumonia e mapa de calor de raio-X do tórax usando redes neurais convolucionais.

- piloto automático Tesla – Multitarefa de visão computacional em tempo real para veículos autônomos.

- Uber AI Labs PYRO – Linguagem de programação probabilística para modelagem probabilística profunda. Previsão e otimização da correspondência de clientes com motoristas, rotas ideais e veículos inteligentes de última geração.

Você deve usar PyTorch ou TensorFlow?

PyTorch é a opção favorita entre programadores e pesquisadores científicos. A comunidade científica prefere o PyTorch ao analisar o número de citações. Com os recursos recentes de implantação e produção, o PyTorch é uma ótima opção ao passar da pesquisa para a produção.

Organizações e startups geralmente usam o TensorFlow. Os recursos de implantação e produção dão ao TensorFlow uma boa reputação em casos de uso corporativo. A visualização com o Tensorboard também mostra uma apresentação elegante para os clientes.

PyTorch e TensorFlow são poderosas bibliotecas de aprendizado profundo que se desenvolvem intensamente. Hoje, há mais semelhanças do que diferenças entre os dois e mudar de um para o outro é um processo contínuo.

Computação em Nuvem

- AWS e Azure:Visão geral e comparação dos serviços

- IoT na fabricação:um olhar aprofundado

- GPS vs. RFID:uma comparação de tecnologias de localização de ativos

- ZigBee vs. XBee:uma comparação fácil de entender

- Comparação de torno CNC para madeira tradicional

- Divisor de tensão capacitivo:um guia detalhado

- Comparação de tecnologias 3D:SLA x FDM

- Uma visão aprofundada da bomba de água centrífuga

- Uma comparação de afiação e lapidação

- Comparação de esteiras transportadoras de mineração