O relatório ETSI abre caminho para padronizar a segurança de IA

Um novo relatório do ETSI, a organização europeia de normalização para redes e serviços de telecomunicações, radiodifusão e comunicações eletrónicas, visa preparar o caminho para o estabelecimento de uma norma para a segurança de inteligência artificial (IA).

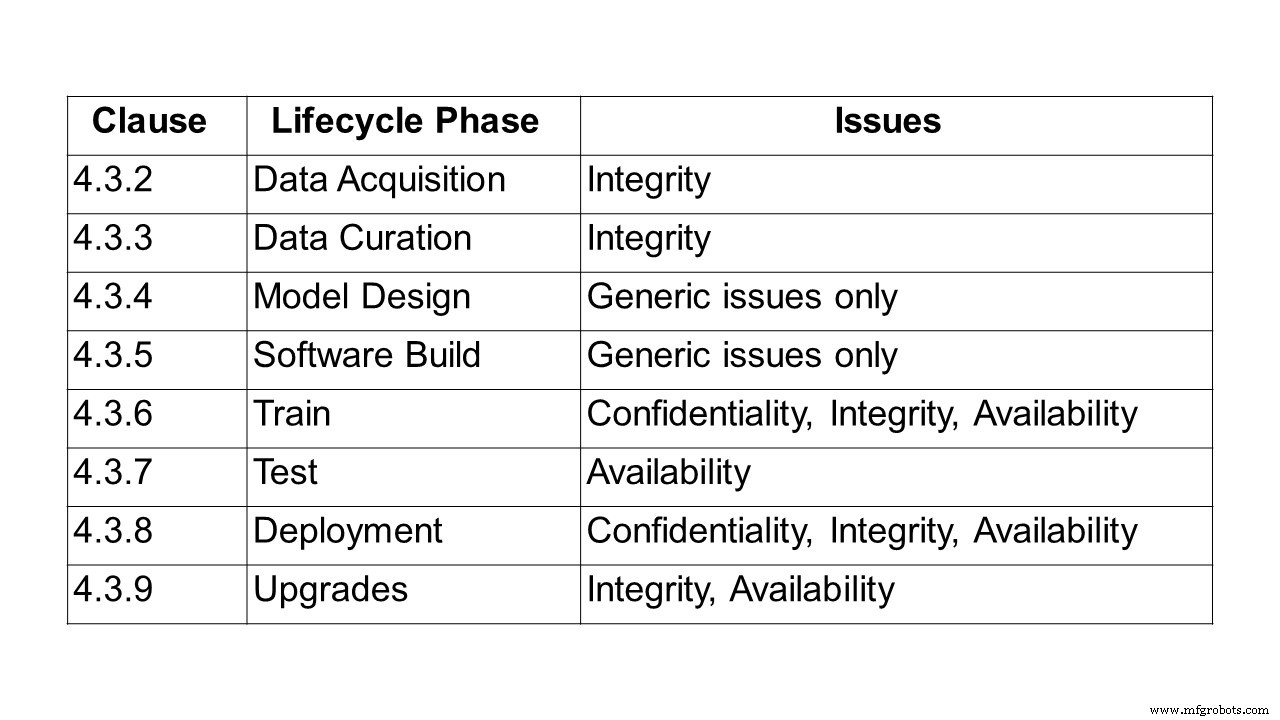

A primeira etapa no caminho para a criação de um padrão é descrever o problema de proteção de sistemas e soluções baseados em IA. É o que faz o relatório de 24 páginas ETSI GR SAI 004, o primeiro a ser publicado pelo Grupo de Especificação da Indústria de Inteligência Artificial de Segurança ETSI (SAI ISG). Ele define a declaração do problema e tem um foco específico no aprendizado de máquina (ML) e nos desafios relacionados à confidencialidade, integridade e disponibilidade em cada estágio do ciclo de vida do aprendizado de máquina. Ele também aponta alguns dos desafios mais amplos dos sistemas de IA, incluindo preconceito, ética e capacidade de explicação. Vários vetores de ataque diferentes são descritos, bem como vários casos de uso e ataques no mundo real.

Para identificar os problemas envolvidos na proteção da IA, a primeira etapa foi definir a IA. Para o grupo ETSI, inteligência artificial é a capacidade de um sistema de lidar com representações, tanto explícitas quanto implícitas, e procedimentos para realizar tarefas que seriam consideradas inteligentes se realizadas por um ser humano. Essa definição ainda representa um amplo espectro de possibilidades. No entanto, um conjunto limitado de tecnologias está se tornando viável, em grande parte impulsionado pela evolução das técnicas de aprendizado de máquina e de aprendizado profundo, e pela ampla disponibilidade de dados e poder de processamento necessário para treinar e implementar tais tecnologias.

Inúmeras abordagens de aprendizado de máquina são de uso comum, incluindo aprendizado supervisionado, não supervisionado, semissupervisionado e de reforço.

- Aprendizagem supervisionada - em que todos os dados de treinamento são rotulados e o modelo pode ser treinado para prever a saída com base em um novo conjunto de entradas.

- Aprendizagem semissupervisionada - onde o conjunto de dados é parcialmente rotulado. Nesse caso, mesmo os dados não rotulados podem ser usados para melhorar a qualidade do modelo.

- Aprendizagem não supervisionada - em que o conjunto de dados não está rotulado e o modelo procura a estrutura dos dados, incluindo agrupamento e clustering.

- Aprendizagem por reforço - onde uma política que define como agir é aprendida pelos agentes através da experiência para maximizar sua recompensa; e os agentes ganham experiência ao interagir em um ambiente por meio de transições de estado.

Dentro desses paradigmas, uma variedade de estruturas de modelo pode ser usada, com uma das abordagens mais comuns sendo o uso de redes neurais profundas, onde o aprendizado é realizado em uma série de camadas hierárquicas que imitam o comportamento do cérebro humano.

Também podem ser utilizadas várias técnicas de treino, nomeadamente a aprendizagem adversária, em que o conjunto de treino contém não apenas amostras que reflectem os resultados pretendidos, mas também amostras adversárias, que se destinam a desafiar ou perturbar o comportamento esperado.

“Há muitas discussões sobre a ética da IA, mas nenhuma sobre os padrões de proteção da IA. Ainda assim, eles estão se tornando essenciais para garantir a segurança de redes automatizadas baseadas em IA. Este primeiro relatório do ETSI pretende apresentar uma definição abrangente dos desafios enfrentados ao proteger a IA. Paralelamente, estamos trabalhando em uma ontologia de ameaças, em como proteger uma cadeia de suprimento de dados de IA e como testá-la ”, explica Alex Leadbeater, presidente do ETSI SAI ISG.

Questionado sobre os cronogramas, Leadbeater disse a embedded.com:“Mais 12 meses é uma estimativa razoável para as especificações técnicas. Há mais relatórios técnicos chegando nos próximos trimestres (AI Threat Ontology, Data Supply Chain Report, SAI Mitigation Strategy report). Na verdade, uma especificação sobre teste de segurança de IA deve ser lançada antes, por volta do final do segundo / terceiro trimestre. As próximas etapas serão identificar áreas específicas na declaração do problema que podem ser expandidas em itens de trabalho informativos mais detalhados. ”

Esboço do relatório

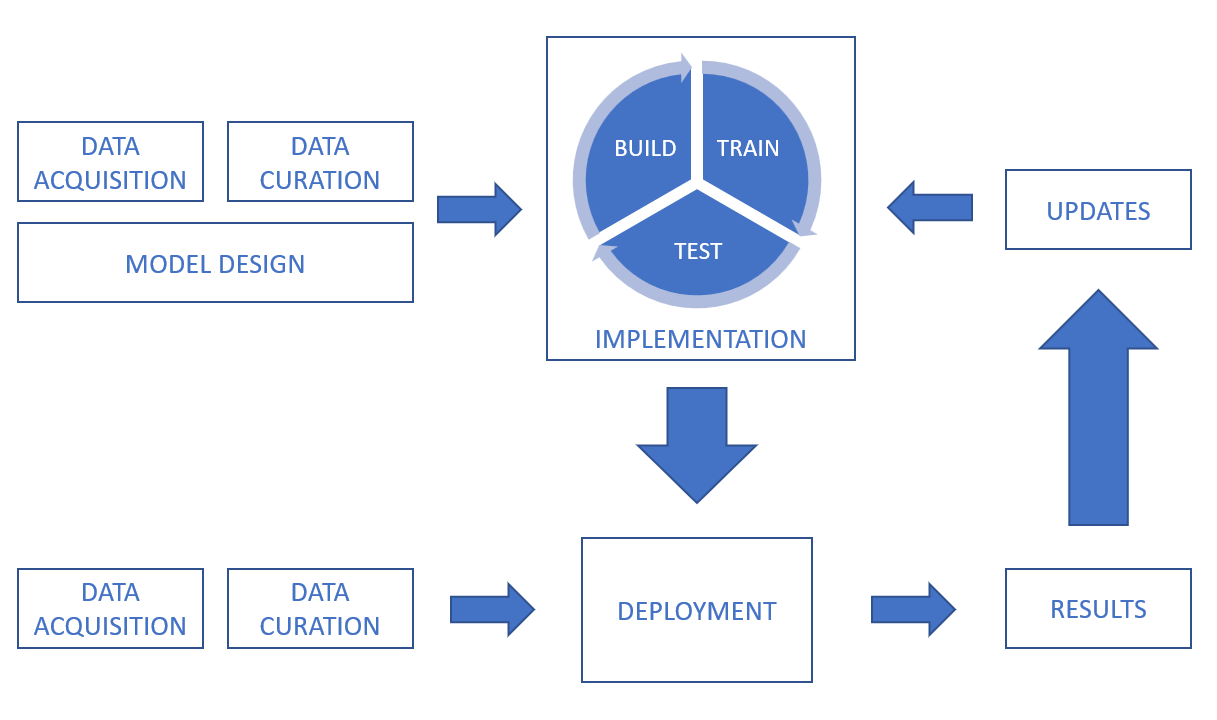

Seguindo a definição de IA e aprendizado de máquina, o relatório analisa a cadeia de processamento de dados, cobrindo os desafios de confidencialidade, integridade e disponibilidade em todo o ciclo de vida, desde aquisição de dados, curadoria de dados, design de modelo e construção de software, até treinamento, teste, implantação e inferência e atualizações.

Em um sistema de IA, os dados podem ser obtidos de uma infinidade de fontes, incluindo sensores (como câmeras de CFTV, telefones celulares, dispositivos médicos) e ativos digitais (como dados de plataformas de negociação, extratos de documentos, arquivos de log). Os dados também podem estar em muitas formas diferentes (incluindo texto, imagens, vídeo e áudio) e podem ser estruturados ou não estruturados. Além dos desafios de segurança relacionados aos dados em si, é importante considerar a segurança de transmissão e armazenamento.

Para dar uma indicação dos desafios de integridade na curadoria de dados, ao reparar, aumentar ou converter conjuntos de dados, é importante garantir que os processos não corram o risco de impactar a qualidade e integridade dos dados. Para sistemas supervisionados de aprendizado de máquina, é importante que a rotulagem de dados seja precisa e o mais completa possível e para garantir que a rotulagem mantenha sua integridade e não seja comprometida, por exemplo, por meio de ataques de envenenamento. Também é importante abordar o desafio de garantir que o conjunto de dados seja imparcial. As técnicas de aumento de dados podem afetar a integridade dos dados.

Outra área coberta é em torno dos desafios de design, outros fatores não intencionais em torno de preconceito, ética de dados e explicabilidade.

Por exemplo, o viés deve ser considerado não apenas durante as fases de projeto e treinamento, mas também depois que um sistema foi implantado, já que o viés ainda pode ser introduzido. O relatório cita um exemplo de 2016, quando um chatbot foi lançado, que pretendia ser um experimento de “compreensão conversacional”. O chatbot se envolveria com usuários de redes sociais por meio de tweets e mensagens diretas. Em questão de horas, o chatbot estava começando a tweetar mensagens altamente ofensivas. Depois que o chatbot foi retirado, foi descoberto que a conta do chatbot tinha sido manipulada para exibir comportamento tendencioso por trolls da internet. A polarização não representa necessariamente um problema de segurança, mas pode simplesmente resultar no sistema não atender aos seus requisitos funcionais.

Sobre ética, o relatório destaca vários exemplos, incluindo carros autônomos e saúde. Ele cita um artigo da Universidade de Brighton que discutiu um cenário hipotético em que um carro movido a IA atropela um pedestre e explorou as responsabilidades legais decorrentes. Em março de 2018, esse cenário se tornou realidade quando um carro que dirigia sozinho atropelou e matou um pedestre na cidade de Tempe, Arizona. Isso colocou em foco não apenas as responsabilidades legais, mas os desafios éticos potenciais do próprio processo de tomada de decisão. Em 2016, o Massachusetts Institute of Technology (MIT) lançou um site chamado Moral Machine explorando os desafios de permitir que sistemas inteligentes tomem decisões de natureza ética. O site tenta explorar como os humanos se comportam quando confrontados com dilemas éticos e obter uma melhor compreensão de como as máquinas devem se comportar.

O relatório enfatiza que, embora as questões éticas não tenham uma relação direta com as características de segurança tradicionais de confidencialidade, integridade e disponibilidade, elas podem ter um efeito significativo na percepção de um indivíduo sobre se um sistema pode ser confiável. Portanto, é essencial que os projetistas e implementadores de sistemas de IA considerem os desafios éticos e procurem criar sistemas éticos robustos que possam construir a confiança entre os usuários.

Por fim, o relatório analisa os tipos de ataque, de envenenamento e ataques de backdoor à engenharia reversa, seguidos de casos de uso e ataques do mundo real.

Em um ataque de envenenamento, um atacante busca comprometer o modelo de IA, normalmente durante a fase de treinamento, para que o modelo implantado se comporte da maneira que o atacante deseja. Isso pode ser devido à falha do modelo com base em certas tarefas ou entradas, ou porque o modelo aprende um conjunto de comportamentos que são desejáveis para o invasor, mas não pretendidos pelo designer do modelo. Ataques de envenenamento geralmente podem ocorrer de três maneiras:

- envenenamento de dados - em que o invasor introduz dados incorretos ou incorretamente rotulados no conjunto de dados durante as fases de coleta ou curadoria de dados.

- Envenenamento por algoritmo - quando um invasor interfere nos algoritmos usados para o processo de aprendizagem. Por exemplo, o aprendizado federado envolve o treinamento de modelos individuais em subconjuntos de dados e, a seguir, a combinação dos modelos aprendidos para formar o modelo final. Isso significa que os conjuntos de dados individuais permanecem privados, mas criam uma vulnerabilidade inerente. Uma vez que qualquer conjunto de dados individual pode ser controlado por um invasor, eles podem manipular essa parte do modelo de aprendizado diretamente e influenciar o aprendizado geral do sistema.

- Envenenamento por modelo - quando todo o modelo implantado é simplesmente substituído por um modelo alternativo. Este tipo de ataque é semelhante a um ataque cibernético tradicional em que os arquivos eletrônicos que compõem o modelo podem ser alterados ou substituídos.

Embora o termo "inteligência artificial" tenha se originado em uma conferência na década de 1950 no Dartmouth College em Hanover, New Hampshire, EUA, os casos de uso na vida real descritos no relatório do ETSI mostram o quanto ele evoluiu desde então. Esses casos incluem ataques de bloqueadores de anúncios, ofuscação de malware, deepfakes, reprodução de caligrafia, voz humana e conversa falsa (que já gerou muitos comentários em chatbots).

O que vem a seguir? Relatórios em andamento como parte deste ISG

Este grupo de especificações do setor (ISG) está analisando vários relatórios em andamento, pois os itens de trabalho serão aprofundados.

Teste de segurança :O objetivo deste item de trabalho é identificar objetivos, métodos e técnicas que são apropriados para o teste de segurança de componentes baseados em IA. O objetivo geral é ter diretrizes para testes de segurança de IA e componentes baseados em IA, levando em consideração os diferentes algoritmos de IA simbólica e subsimbólica e abordando ameaças relevantes do item de trabalho “Ontologia de ameaça de IA”. O teste de segurança de IA tem alguns pontos em comum com o teste de segurança de sistemas tradicionais, mas oferece novos desafios e requer abordagens diferentes, devido a

(a) diferenças significativas entre a IA simbólica e subsimbólica e os sistemas tradicionais que têm fortes implicações na sua segurança e na forma de testar as suas propriedades de segurança;

(b) não determinismo, uma vez que os sistemas baseados em IA podem evoluir ao longo do tempo (sistemas de autoaprendizagem) e as propriedades de segurança podem degradar;

(c) problema de oráculo de teste, atribuir um veredicto de teste é diferente e mais difícil para sistemas baseados em IA, uma vez que nem todos os resultados esperados são conhecidos a priori, e (d) algoritmos baseados em dados:em contraste com sistemas tradicionais, dados (de treinamento) forma o comportamento da IA subsimbólica.

O escopo deste item de trabalho em testes de segurança é cobrir os seguintes tópicos (mas não limitado a):

- abordagens de teste de segurança para IA

- dados de teste para IA do ponto de vista da segurança

- oráculos de teste de segurança para IA

- definição de critérios de adequação de teste para teste de segurança de IA

- objetivos de teste para atributos de segurança de IA

E fornece diretrizes para testes de segurança de IA levando em consideração os tópicos mencionados acima. As diretrizes usarão os resultados do item de trabalho “AI Threat Ontology” para cobrir ameaças relevantes para IA por meio de testes de segurança e também abordarão os desafios e limitações ao testar o sistema baseado em IA.

Ontologia de ameaça de IA :O objetivo deste item de trabalho é definir o que seria considerado uma ameaça de IA e como pode ser diferente das ameaças aos sistemas tradicionais. O ponto de partida que oferece a justificativa para este trabalho é que, atualmente, não há um entendimento comum sobre o que constitui um ataque à IA e como ele pode ser criado, hospedado e propagado. O produto final do item de trabalho “Ontologia de ameaças de IA” buscará alinhar a terminologia entre as diferentes partes interessadas e vários setores. Este documento definirá o que esses termos significam no contexto de segurança cibernética e física e com uma narrativa que deve ser prontamente acessível por especialistas e públicos menos informados em vários setores. Observe que esta ontologia de ameaça tratará a IA como sistema, um atacante adversário e como um defensor do sistema.

Relatório da cadeia de abastecimento de dados :Os dados são um componente crítico no desenvolvimento de sistemas de IA. Isso inclui dados brutos, bem como informações e feedback de outros sistemas e humanos no loop, todos os quais podem ser usados para alterar a função do sistema, treinando e retreinando a IA. No entanto, o acesso a dados adequados é frequentemente limitado, causando a necessidade de recorrer a fontes de dados menos adequadas. Comprometer a integridade dos dados de treinamento demonstrou ser um vetor de ataque viável contra um sistema de IA. Isso significa que proteger a cadeia de fornecimento de dados é uma etapa importante para proteger a IA. Este relatório resumirá os métodos usados atualmente para obter dados para treinamento de IA, juntamente com os regulamentos, padrões e protocolos que podem controlar o manuseio e o compartilhamento desses dados. Em seguida, ele fornecerá uma análise de lacunas sobre essas informações para definir os possíveis requisitos de padrões para garantir a rastreabilidade e integridade dos dados, atributos associados, informações e feedback, bem como a confidencialidade destes.

Estratégia de mitigação de SAI relatório:Este item de trabalho tem como objetivo resumir e analisar mitigação existente e potencial contra ameaças para sistemas baseados em IA. O objetivo é ter diretrizes para mitigar as ameaças introduzidas pela adoção de IA nos sistemas. Essas diretrizes lançarão linhas de base de proteção de sistemas baseados em IA, atenuando contra ameaças de segurança conhecidas ou potenciais. Eles também abordam os recursos, desafios e limitações de segurança ao adotar a mitigação para sistemas baseados em IA em certos casos de uso em potencial.

? O papel do hardware na segurança da IA: Preparar um relatório que identifique a função do hardware, tanto especializado quanto de uso geral, na segurança da IA. Isso resolverá as atenuações disponíveis no hardware para evitar ataques e também atenderá aos requisitos gerais de hardware para oferecer suporte a SAI. Além disso, este relatório abordará possíveis estratégias de uso de IA para proteção de hardware. O relatório também fornecerá um resumo da experiência acadêmica e industrial em segurança de hardware para IA. Além disso, o relatório abordará vulnerabilidades ou fraquezas introduzidas pelo hardware que podem amplificar vetores de ataque em IA.

O relatório ETSI completo que define a declaração do problema para proteger a IA está disponível aqui.

Tecnologia da Internet das Coisas

- Dicas de segurança IIoT e tendências para 2020

- Uma receita para segurança industrial:Uma pitada de TI, uma pitada de OT e uma pitada de SOC

- A busca por um padrão universal de segurança IoT

- TI:A tecnologia de ressonador BAW abre caminho para comunicações de próxima geração

- Guia de segurança cibernética publicado para usuários de negócios na nuvem

- Relate as chamadas para ação urgente para enfrentar a ameaça cibernética à infraestrutura crítica

- Três etapas para segurança global de IoT

- Um guia de quatro etapas para garantia de segurança para dispositivos Iot

- O que a chegada do 5G significa para a segurança da IoT

- A penalidade de reivindicações ‘Made in USA’ da FTC abre caminho para aplicação adicional