Ferramentas Mova a Cadeia de Valor para Retirar o Mistério da Visão AI

Os benefícios de adicionar visão aos produtos do dia-a-dia têm atraído a atenção de muitas indústrias e setores. Mas como você realmente obtém dados de uma câmera, incorpora o aprendizado de máquina no dispositivo para realizar o algoritmo de inferência e permite que algo útil seja processado?

A resposta, como em qualquer projeto de sistema, é ter o software, as ferramentas, as bibliotecas, os compiladores certos e assim por diante. Não é surpresa que tais recursos estejam geralmente além do alcance de não engenheiros. Mas mesmo entre os desenvolvedores de sistemas embarcados, o conhecimento e as habilidades necessárias para o projeto de sistemas de visão são considerados escassos.

Um dos grandes desafios é a falta de conhecimento do software e das ferramentas disponíveis para o desenvolvimento de sistemas de visão incorporados, como Jeff Bier, fundador da Edge AI e Vision Alliance, explicou em um briefing com EE Timesahead do 2021 Embedded Vision Summit . Embora tenha havido um investimento significativo e pesquisas sobre os algoritmos e o silício, as ferramentas de software que fazem a mediação entre eles - compiladores, bibliotecas de funções otimizadas e assim por diante - foram um tanto negligenciadas, disse Bier.

Usar as ferramentas de software, compiladores e bibliotecas corretas pode gerar uma implementação muito eficiente de um algoritmo para um microcontrolador ou processador específico. Mas “nos últimos 30 anos, as empresas de semicondutores têm investido pouco em ferramentas de software”, disse Bier, um veterano da indústria de sistemas embarcados e processamento de sinais em particular. “[Software] é muitas vezes visto como um mal necessariamente - é um centro de custo em um negócio muito sensível a custos - e isso mostra. Como um desenvolvedor de software embarcado, você pode olhar para as ferramentas disponíveis [para você] em comparação com o que os desenvolvedores de PC ou nuvem têm e se sentir como um enteado não amado. ”

Levando esse argumento para o próximo nível, ele acrescentou:“Você pode ter experiência em sistemas embarcados, mas há uma chance de que esses desenvolvedores nunca tenham trabalhado com dados de imagem ou redes neurais profundas”.

As habilidades são um grande desafio, disse Bier. “Podemos ter feito alguns cálculos em planilhas e dito:‘ Sim, é possível executar esse tipo de rede neural profunda com desempenho suficiente em nosso aplicativo ’. Mas será que sabemos como fazer isso? Temos as habilidades? Para a maioria das organizações, a resposta é não, porque não tiveram a oportunidade de usar essa tecnologia no passado. Uma vez que é uma tecnologia relativamente nova no mundo comercial, eles não têm o conhecimento necessário. Eles não têm um departamento de aprendizado de máquina ou um departamento de visão computacional em sua empresa.

“Nos últimos dois anos, isso se tornou um gargalo muito grande no que diz respeito à aplicação comercial de visão computacional e redes neurais profundas - apenas o know-how.”

A tecnologia está se tornando mais acessível, no entanto, à medida que as empresas têm procurado resolver a lacuna de habilidades nos últimos dois anos. “A lacuna de conhecimento e habilidades tem sido muito grande, mas está ficando menor”, disse Bier, acrescentando que “algumas empresas”, uma grande e outra pequena, “lideraram o processo”. A grande empresa é a Intel; o menor é o Edge Impulse.

“A Intel sempre me impressionou por contrariar a tendência e querer fazer grandes investimentos em ferramentas de software de várias maneiras”, disse Bier. “Eles têm, por exemplo, a cadeia de ferramentas OpenVINO para visão computacional de ponta e inferência e DevCloud para a borda. O Edge Impulse também é um ambiente baseado em nuvem. Para um desenvolvedor embarcado, isso [o ambiente de nuvem] parece estranho. Tudo para eles geralmente está em suas mesas - a placa de desenvolvimento, a estação de trabalho, as ferramentas - e eles nem mesmo precisam de uma conexão com a internet. Tudo é muito local. Portanto, parece muito estranho dizer, ‘Coloque seu código na nuvem’ e execute as ferramentas na nuvem. ”

A tendência aborda o tempo de implantação, bem como a lacuna de habilidades. Uma frustração frequente para desenvolvedores embarcados é obter acesso a placas e ferramentas e instalá-los corretamente, disse Bier. O cronograma é "geralmente medido em semanas, às vezes em meses, e isso é doloroso, especialmente se no final você perceber que não é o que você precisa e precisa repetir o processo com alguns outros painéis." Por exemplo, você pode descobrir no final do processo que “você precisa do próximo, com melhor desempenho ou um conjunto diferente de interfaces de E / S”.

Mas se o fornecedor “tiver todas as placas de desenvolvimento na nuvem conectadas às suas máquinas e [puder] acessá-las à vontade, isso oferece uma tremenda conveniência. Da mesma forma, eles têm as versões mais recentes das ferramentas de software e resolveram todas as dependências entre eles. ”

Pavimentando o caminho para a implementação da visão

Então, como você acelera a implantação da visão incorporada para habilitar recursos como detecção e análise de objetos, seja para cidades inteligentes, fábricas, varejo ou qualquer outro aplicativo?

Tendo percebido os pontos problemáticos descritos por Bier, as empresas estão lidando com eles. Alguns agora oferecem ferramentas, como sistemas de desenvolvimento baseados em nuvem, que permitem que você alimente seu código ou dados e obtenha avaliações rapidamente. Outros fornecem designs de referência que permitem simplesmente conectar a saída da câmera e escolher entre bibliotecas ou aplicativos que fornecem algoritmos de inferência para aplicativos comuns.

No antigo campo, a Intel DevCloud for the Edge e Edge Impulse oferecem plataformas baseadas em nuvem que eliminam a maioria dos pontos problemáticos com fácil acesso às ferramentas e softwares mais recentes. No último, Xilinx e outros começaram a oferecer sistemas completos em módulos com aplicativos prontos para produção que podem ser implantados com ferramentas em um nível mais alto de abstração, eliminando a necessidade de algumas das habilidades mais especializadas.

Protótipo, benchmark e teste de inferência de IA na nuvem

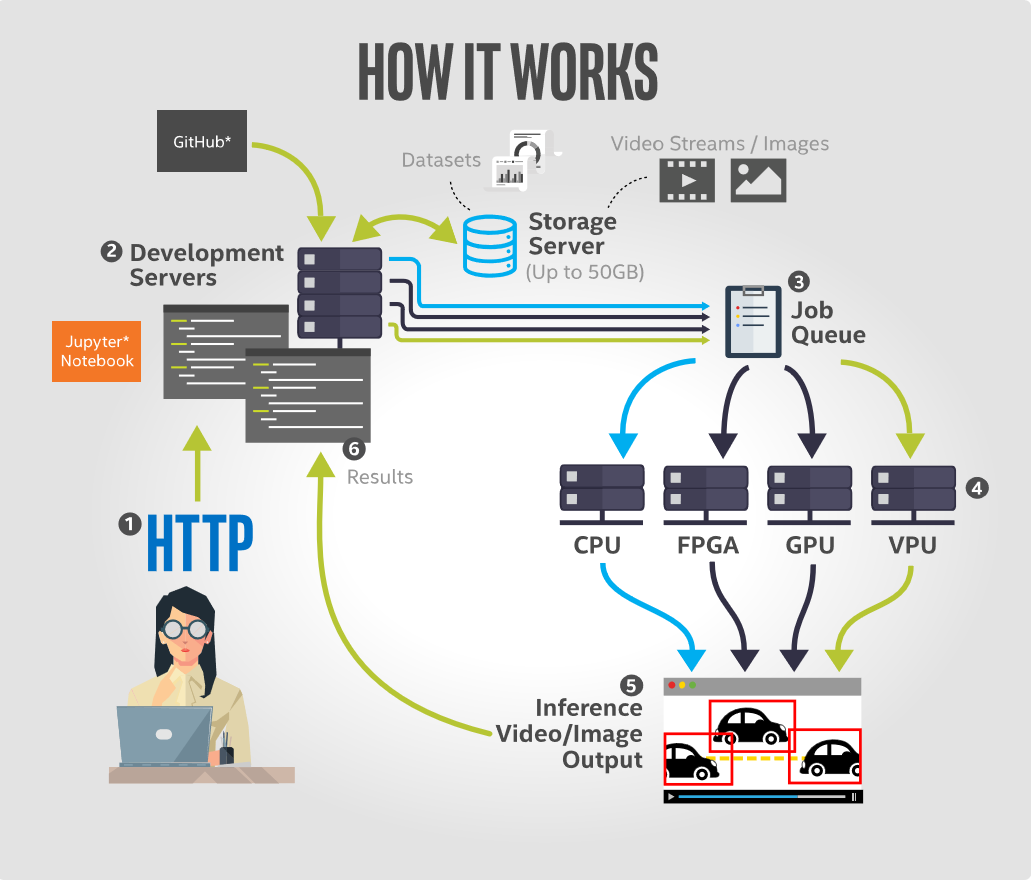

O Intel DevCloud for the Edge permite que os usuários desenvolvam, prototipem, comparem e testem aplicativos de inferência de IA em uma variedade de hardware Intel, incluindo CPUs, GPUs integradas, FPGAs e unidades de processamento de visão (VPUs). Com sua interface do Jupyter Notebook, a plataforma contém tutoriais e exemplos pré-carregados com tudo o que é necessário para começar a funcionar rapidamente. Isso inclui modelos pré-treinados, dados de amostra e código executável da versão mais recente da distribuição da Intel do kit de ferramentas OpenVINO, bem como outras ferramentas para aprendizado profundo. Todos os dispositivos de suporte são configurados para desempenho ideal e prontos para execução de inferência.

O benefício mais significativo para o desenvolvedor é que a plataforma não requer nenhuma configuração de hardware por parte do usuário. O ambiente de desenvolvimento baseado em navegador do Jupyter Notebook permite que os desenvolvedores executem códigos de dentro de seus navegadores e visualizem os resultados instantaneamente. Isso permite que eles desenvolvam protótipos de soluções de visão computacional no ambiente de nuvem da Intel e vejam seu código ser executado em qualquer combinação de seus recursos de hardware disponíveis.

Existem três benefícios principais para esta oferta baseada em nuvem. Primeiro, ele aborda a questão da paralisia da escolha de hardware. Os desenvolvedores podem executar aplicativos de IA remotamente em uma ampla variedade de hardware para determinar qual é o melhor para sua solução com base em fatores como tempo de execução de inferência, consumo de energia e custo.

Em segundo lugar, ele oferece acesso remoto imediato ao mais recente hardware Intel Edge. No lado do software, ele aborda a questão de ter que lidar com software desatualizado, uma vez que fornece acesso instantâneo à versão mais recente do kit de ferramentas de distribuição da Intel OpenVINO e hardware compatível de ponta.

E terceiro, ele oferece acesso a benchmarks de desempenho específicos de aplicativos em um formato lado a lado fácil de comparar.

(Um tutorial sobre a execução de modelos de detecção de objetos usando Intel DevCloud for the Edge está disponível aqui.)

Construa um modelo na nuvem, veja o que acontece ao vivo

Outra abordagem é alimentar dados em uma plataforma de nuvem para visualizar e criar modelos de treinamento e implantá-los em dispositivos embarcados. O Edge Impulse faz exatamente isso, oferecendo um ambiente de desenvolvimento baseado em nuvem que visa simplificar a adição de aprendizado de máquina em dispositivos de ponta sem a necessidade de um doutorado. em aprendizado de máquina, de acordo com a empresa.

Sua plataforma permite que os usuários importem dados de imagem coletados em campo, construam classificadores rapidamente para interpretar esses dados e implantem modelos de volta em dispositivos de produção de baixo consumo de energia. Uma chave para a plataforma da web Edge Impulse é a capacidade de visualizar e rotular todos os dados adquiridos, criar blocos de pré-processamento para aumentar e transformar dados, visualizar o conjunto de dados de imagem e classificar e validar modelos em dados de treinamento diretamente da interface do usuário.

Como pode ser muito difícil construir um modelo de visão computacional do zero, o Edge Impulse usa um processo de aprendizagem por transferência para tornar mais fácil e rápido o treinamento de modelos. Isso envolve pegar carona em um modelo bem treinado e retreinar apenas as camadas superiores de uma rede neural, levando a modelos muito mais confiáveis que treinam em uma fração do tempo e funcionam com conjuntos de dados substancialmente menores. Com o modelo projetado, treinado e verificado, é então possível implantar este modelo de volta no dispositivo. O modelo pode então ser executado no dispositivo sem uma conexão com a Internet, com todos os seus benefícios inerentes, como minimizar a latência, e funciona com consumo mínimo de energia. O modelo completo é empacotado com etapas de pré-processamento, pesos de rede neural e código de classificação em uma única biblioteca C ++ que pode ser incluída no software embarcado.

Indo para um nível mais alto de abstração

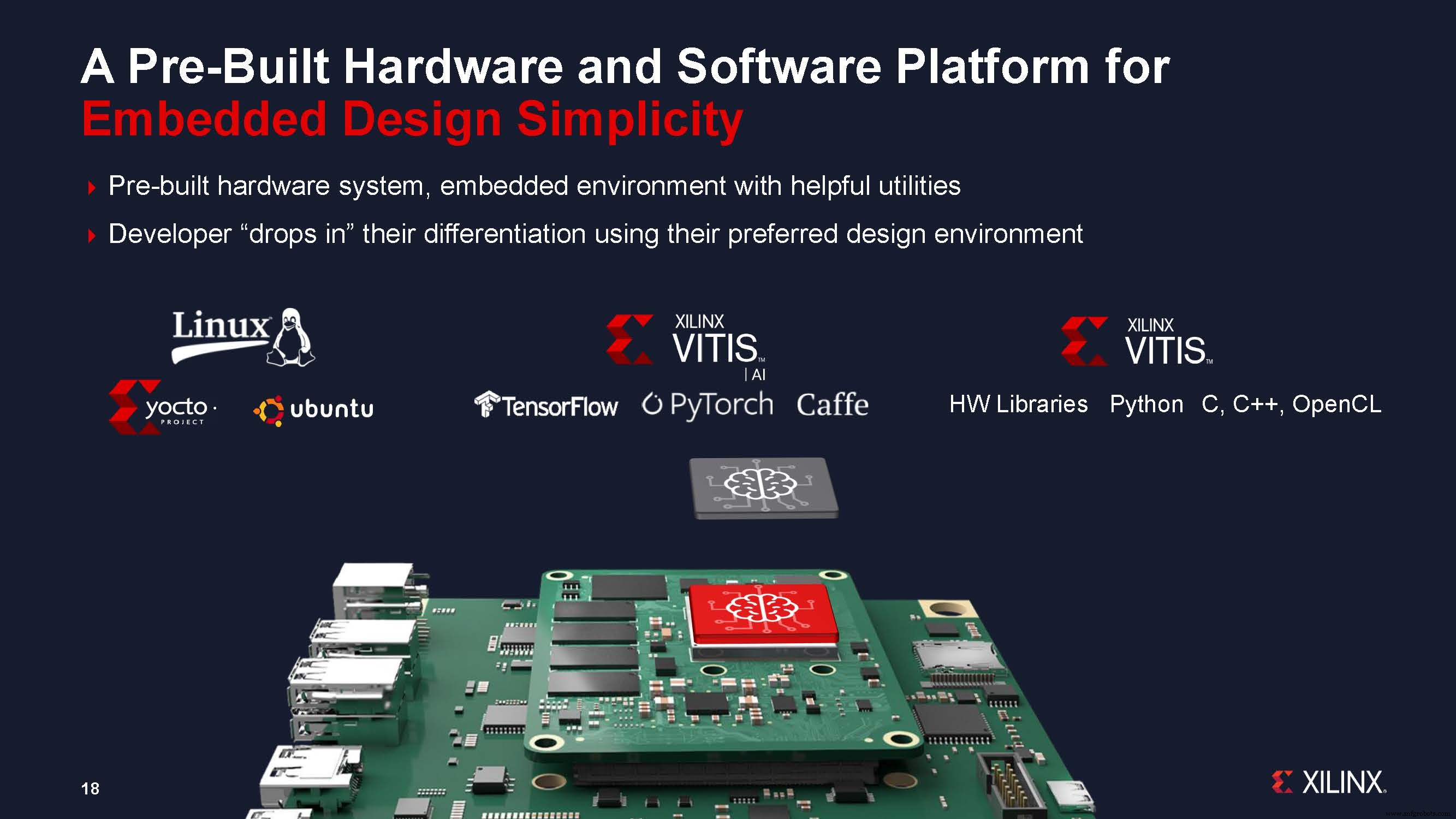

Outra abordagem oferecida pelos fornecedores é reduzir o tempo de desenvolvimento, oferecendo sistemas baseados em módulo e permitindo o design em um nível mais alto de abstração. A Xilinx disse que sua nova abordagem de sistemas em módulo (SOMs) pode reduzir em até nove meses o tempo de desenvolvimento de sistemas de visão, ao abordar a complexidade crescente da IA de visão, bem como os desafios para a implementação de IA na borda.

A Xilinx anunciou recentemente o primeiro produto em seu novo portfólio de SOMs:o Kria K26 SOM, voltado especificamente para aplicações de IA de visão em cidades e fábricas inteligentes, junto com um kit de desenvolvimento pronto para uso e de baixo custo, o Kria Kit inicial KV260 AI vision.

Chetan Khona, diretor industrial, de visão e de saúde da Xilinx, disse na coletiva de imprensa para o lançamento da nova família de módulos:“Os sistemas prontos para produção são importantes para a implantação rápida [de IA de visão incorporada]. Os clientes podem economizar até nove meses no tempo de desenvolvimento usando um design baseado em módulo em vez de um design baseado em dispositivo. ” Ele acrescentou que, com o kit inicial, os usuários podem começar em uma hora, “sem a necessidade de experiência em FPGA”. Os usuários conectam a câmera, os cabos e o monitor, inserem o cartão microSD programado e ligam a placa, e então podem selecionar e executar um aplicativo acelerado de sua escolha.

O portfólio Kria SOM combina a plataforma de hardware e software com aplicativos acelerados de visão prontos para produção. Esses aplicativos turnkey eliminam todo o trabalho de design de hardware FPGA; os desenvolvedores de software precisam apenas integrar seus modelos de IA personalizados e código de aplicativo e, opcionalmente, modificar o pipeline de visão - usando ambientes de design familiares, como estruturas TensorFlow, Pytorch ou Café, bem como linguagens de programação C, C ++, OpenCL e Python.

Os SOMs Kria também permitem a personalização e otimização para desenvolvedores embarcados com suporte para PetaLinux baseado em Yocto padrão. Xilinx disse que uma colaboração com a Canonical também está em andamento para fornecer suporte ao Ubuntu Linux, a distribuição Linux altamente popular usada por desenvolvedores de IA. Isso oferece ampla familiaridade com os desenvolvedores de IA e interoperabilidade com os aplicativos existentes. Os clientes podem desenvolver em qualquer ambiente e adotar qualquer abordagem de produção. Ambos os ambientes virão pré-construídos com uma infraestrutura de software e utilitários úteis.

Destacamos três das abordagens que os fornecedores estão adotando para resolver a lacuna de habilidades e conhecimento, bem como o tempo de implantação, para o desenvolvimento de sistemas de visão incorporados. As abordagens baseadas em nuvem oferecem ferramentas que “democratizam” a capacidade de criar e treinar modelos e avaliar hardware para implantação extremamente rápida em dispositivos embarcados. E a abordagem que oferece um módulo, ou design de referência, com uma biblioteca de aplicativos permite que os desenvolvedores de IA usem as ferramentas existentes para criar sistemas de visão incorporados rapidamente. Tudo isso está nos levando a uma maneira diferente de encarar as placas e ferramentas de desenvolvimento. Eles eliminam o mistério da visão incorporada ao subir na cadeia de valor, deixando o trabalho de nível básico para as ferramentas e módulos dos fornecedores.

Conteúdos Relacionados :

- Visão incorporada no ponto crítico

- Cinco tendências para observar no Embedded Vision e Edge AI

- As máquinas compreenderão totalmente o que estão vendo?

- Xilinx SOM visa a adoção mais ampla de IA de ponta e visão incorporada

- Embedded Vision Summit:percepção de ML em pequenos FPGAs

- GWM adota Ambarella AI vision SoC para novo SUV

- AImotive mostra 98% de eficiência de visão de borda no Nextchip Apache5

- A placa de visão de IA de baixo consumo dura ‘anos’ com uma única bateria

- OmniVision reduz o sensor de imagens médicas para endoscopia mais profunda

Integrado

- Inspeção de visão da máquina:Ferramentas do comércio

- Aplicações de IA na cadeia de suprimentos global

- Elimine as suposições nas decisões de manutenção

- Drew Troyer:A cadeia de valor do equipamento, Parte 3

- Drew Troyer:A cadeia de valor do equipamento, Parte 2

- Drew Troyer:A cadeia de valor do equipamento, Parte 1

- O 5G cumprirá a visão de 2020?

- Maximizando o valor dos dados IoT

- O valor da medição analógica

- O potencial da IA na cadeia de suprimentos de saúde